近日,上海人工智能实验室(上海AI实验室)联合香港科技大学、德国图宾根大学、香港大学推出首个大规模自动驾驶视频生成模型GenAD,通过预测和模拟真实世界场景,为自动驾驶技术的研究和应用提供支撑。

视频生成模型GenAD进一步拓宽了自动驾驶技术的研究路径,结合此前推出的端到端自动驾驶模型UniAD、“语言+自动驾驶”全栈数据集DriveLM,上海AI实验室从多个技术维度对自动驾驶技术进行探索,以多方位提升其智能性。

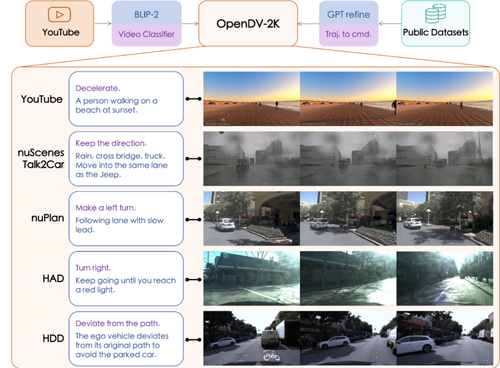

同时,联合团队构建了包含1747小时驾驶视频的数据集OpenDV-YouTube,现已开源。

论文标题:Generalized Predictive Model for Autonomous Driving

论文链接:https://arxiv.org/abs/2403.09630

OpenDV-YouTube数据集开源链接:

https://github.com/OpenDriveLab/DriveAGI

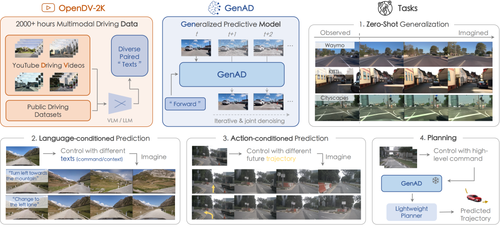

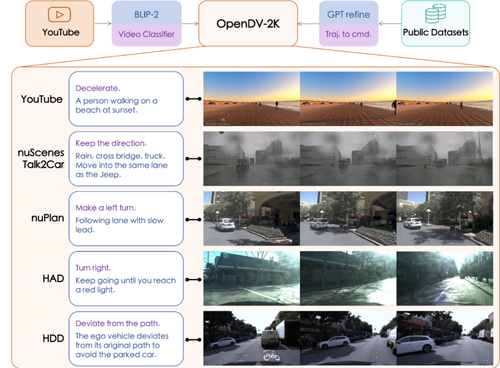

GenAD模型、OpenDV-2K整体概览

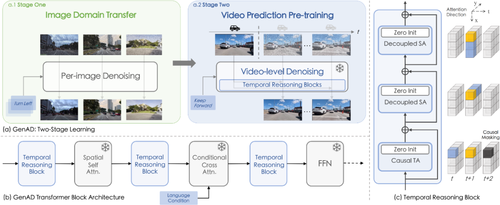

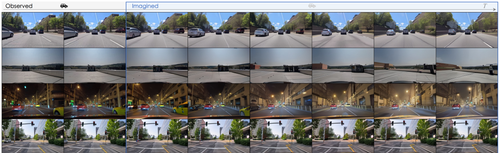

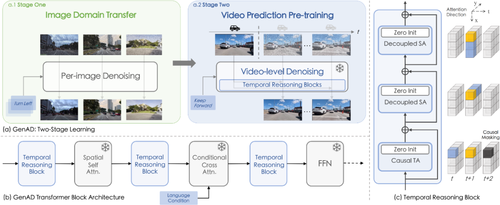

赋予自动驾驶大模型模拟预测真实场景的能力,已成为当前自动驾驶系统性能提升的重要研究思路。由于与现实驾驶场景贴近,第一人称视角驾驶视频有助于使模型从驾驶者角度观察理解周围环境,并仿照真人驾驶者行为进行决策。 受生成式人工智能发展的启发,使用AI生成的高质量第一人称视角驾驶视频受到业界广泛关注。然而,受限于驾驶视频存在动态范围大、运动连续性高等特征,真实驾驶场景存在地理范围多样,自动驾驶专业视频数据缺乏等现实因素,目前的驾驶视频生成模型往往不具备强泛化性,且生成模型质量较低,难以满足研究、应用需求。 为应对该挑战,上海AI实验室联合团队提出GenAD自动驾驶视频生成大模型,提供了场景多样的高质量驾驶视频生成能力,为自动驾驶大模型精准预测决策提供技术支持。 联合团队将开源模型(SDXL)置于驾驶视频数据集OpenDV-2K进行训练,使之获得了第一人称驾驶视角图像的生成能力。随后,设计并引入了因果时序模块,包括为驾驶视频生成特别设计的解耦空间注意力、因果时序注意力和长时序交互机制,并在OpenDV-2K上进行视频预测训练,以此构建起GenAD模型。

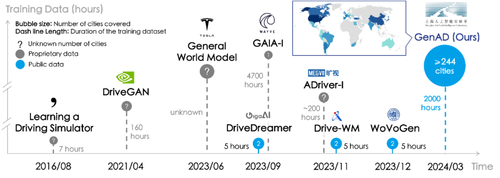

相较于此前的自动驾驶技术,GenAD在理解复杂动态环境、适应开放世界场景、精准预测等方面能力均有较大提升。不仅能够通过语言和行车轨迹进行控制,并具备了用于自动驾驶规划任务的潜力,有助于有效提高行车安全性和效率。 大规模驾驶视频数据集首次开源

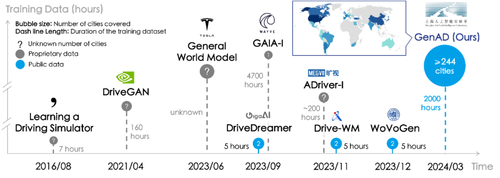

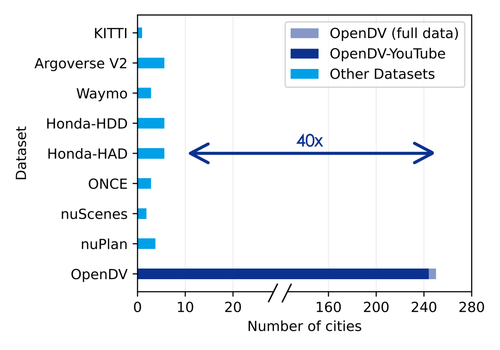

预训练数据集的规模和数据多样性直接影响模型整体性能。由于收集成本较高,当前驾驶领域视频数据集规模均有限,且同一个数据集内的场景、色调、相机参数等较为单一,难以满足自动驾驶视频生成模型的训练需要。

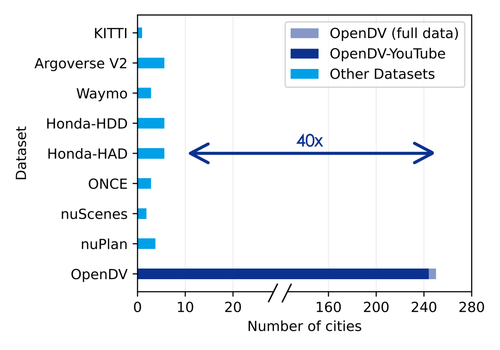

为此联合团队构建了驾驶视频数据集OpenDV-2K。经过视觉语言模型(VLM)筛选、人工质检等工序,数据集收录了2059小时第一人称视角驾驶视频,覆盖超过244个城市场景,规模为当前之最。目前该数据集已用于GenAD预训练,同时向全社会开源。

OpenDV-2K数据集构成

OpenDV-2K覆盖城市数与现有其他驾驶数据集对比 “世界模型”被视为通向通用人工智能(AGI)的重要路径,其可在不实际执行的情况下对未来结果进行预测,从而使模型作出更有效的决策。在自动驾驶领域,特斯拉、Wayve等机构纷纷尝试通过世界模型的研究提升自动驾驶的安全性。 得益于其强大的预测和可泛化能力,涵盖大规模驾驶场景的GenAD为自动驾驶大模型向世界模型迈进提供了重要技术潜力。未来,联合团队将进一步扩展驾驶视频数据集的规模,并持续研究以预测未来能力为核心的基础模型,推动理解复杂世界、三维空间和抽象概念性能提升。